※CCW Orlando 2026 視察レポート 連載記事(全3回)

※著者:網本 信幸(株式会社Proz 代表)

はじめに:会場で感じた「3 年の差」

2026 年 1 月、米国フロリダで開催された CCW(Customer Contact Week) Orlando に参加した。目的は、米国コンタクトセンター市場の最新動向を直接体感することだ。

会場に入った瞬間から感じたのは、日本市場との明確な「温度差」だった。数千人の参加者、数十のセッション――そのいずれにおいても「生成 AI を導入すべきか否か」という議論は皆無だった。議論の焦点は常に「どう使うか」「なぜうまくいかないのか」「次に何が来るのか」だ。

セッションや参加者の様子を観察していて最も印象的だったのは、企業側で何かしらの形で生成 AI の導入は既に行われており、成功と失敗の両方の経験があり、次に進むべき道、取り組む施策も見えている様子だった。

休憩時間のネットワーキングでも、「うちは去年ここに AI を入れたけど最初は失敗した」「でも今はこう改善してうまくいっている」という具体的な経験談が飛び交っていた。

この経験値の蓄積が、私が感じた日本との差だ。決して以前言われていたような5年~10年の遅れではない。しかし、確実に 3 年程度の遅れがある。米国企業は既に試行錯誤を経て、次のステージに入っている。

一方、日本の多くの企業は、まだ「導入すべきか」「どのベンダーを選ぶか」という入口の議論をしている。

進化の段階:米国は既に「Agentic AI」と「Voice AI」の実装段階へ

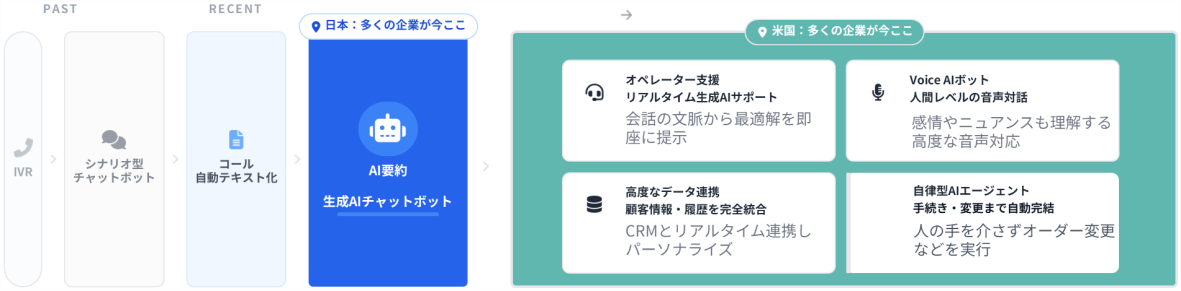

会場で明確に感じ取れたのは、AI 技術の進化における段階の違いだ。私なりに整理すると、こうなる。

IVR➡シナリオ/FAQ ボット/コール文字起こし → AI チャットボット/AI 要約 → Agentic AI / Voice AI

米国の先進企業は既に最後のステージ――Agentic AI とVoice AI の実装フェーズに入っている。一方、日本の多くの企業は、その一つ前の「AI チャットボット」の導入段階。

この差は、セッション内容を見れば一目瞭然だった。日本であれば「生成 AI チャットボットをどう導入するか」がメイントピックになるであろうテーマは、CCW では「前提」として扱われている。

代わりに議論されているのは、「Agentic AI(自律的に判断して業務を完結させるAI)」や「Voice AI(音声での顧客対応AI)」だ。

特にVoice AI の導入は、日本と比較して圧倒的に進んでおり、精度も高い。複数のセッションでVoice AI のデモを見たが、自然な会話の流れ、割り込みへの対応、感情の読み取りなど、そのレベルは想像以上だった。

やはり英語という言語が先行している印象を強く受けた。日本語での Voice AI 実装には、まだ言語特有のハードルがありそうだが確実に同じ波が来ると感じた。

「導入するか」ではなく「どう機能させるか」

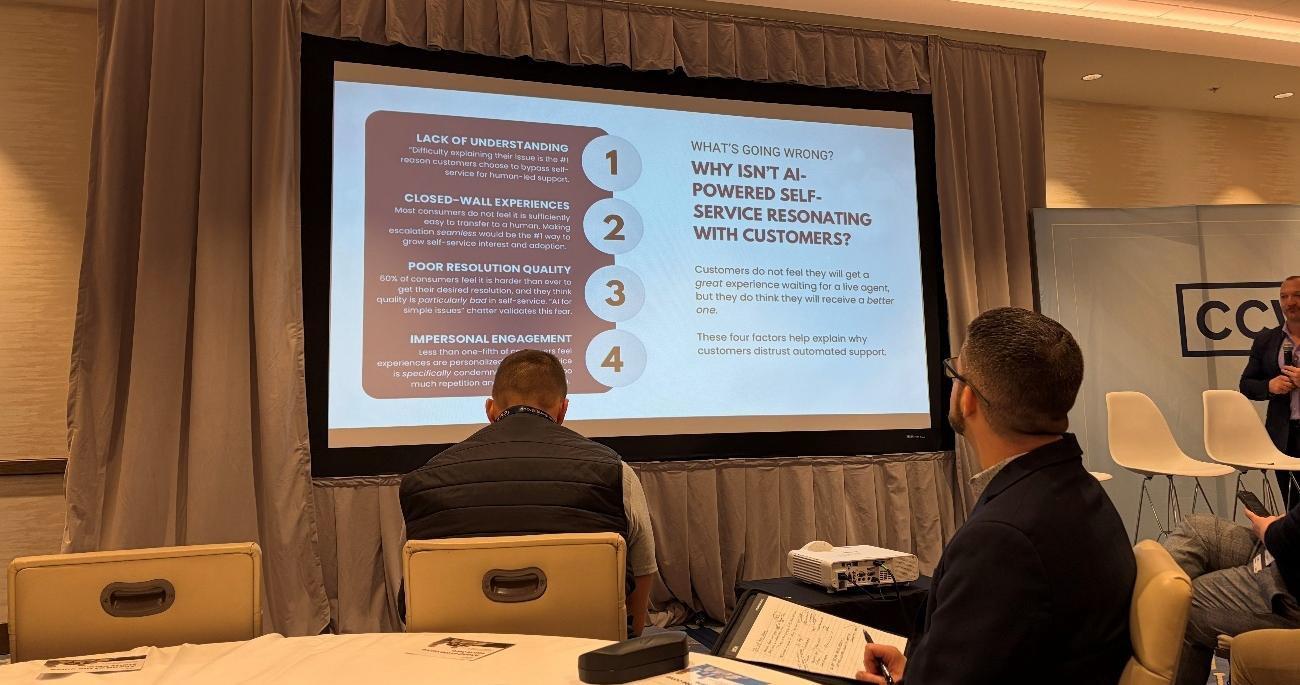

CCW Digital が主導したワークショップ「IN FOCUS: The Self-Service Dilemma」は、私にとって最も刺激的なセッションの一つだった。Managing Director のBrian Cantor 氏、 Divisional Director のBrooke Lynch 氏を中心に、生成 AI 導入後の現実が率直に語られ た。

冒頭で示されたデータが興味深かった。

「74%以上の消費者が今日のカスタマーエクスペリエンスは遅すぎて不便だと感じてい る。さらに問題なのは、チャネル選択の自由がないと訴える顧客が増加していることだ」

「顧客のWeb 自己解決への信頼は、実際に昨年から低下している。顧客の 71%は、やや複雑な問題でも人間のエージェントによるサポートを期待している。そして、AI が自分のジャーニーに価値を加えていると感じている顧客はわずか 29%に過ぎない」

理論的には、生成 AI が多くの課題を解決するはずだった。しかし現実は複雑だ。Cantor氏の指摘は明快だった。

「私たちは顧客の声を十分に聞いていない。その結果、自己解決体験が『エンパワーメント』とは程遠いものになっているケースがある」

このセッションで強く共感したのは、「盲目的な技術導入」への警鐘だ。米国でも、当初 は「生成 AI さえ入れれば問題が解決する」と考えた企業が多かった。

しかし現実は、具体的なプロセスや顧客の体験課題をベースに「どうやったら解決できるか」を検討しなければ、技術だけでは期待した成果は得られない。

この視点は、日本企業がこれから本格的に AI 導入を進める上で極めて重要だ。単に「生成 AI で答えを返す」だけでなく、「顧客の具体的な課題を本当に解決できるか」を常に問う必要がある。

顧客に「選択肢」を提供することの重要性

参加者との対話の中で、ある企業の担当者がこう語った。

「私たちは生成 AI チャットボットを導入し、deflection rate(逸らし率)は確かに上がった。しかし同時に、一部の顧客は、すでにチャットボットの対応に不満を抱えた状態でオペレーターに到達することが多い」

Lynch 氏の分析は的確だった。

「問題は技術そのものではなく、設計思想だ。顧客が提供される自己解決ツールに価値を感じられなければ、それは顧客の時間を奪っているだけになる。そして最終的にエージェントに繋がったとき、そのエージェントに問題を解決する権限が与えられていなければ、顧客体験はさらに悪化する」

この構造的な課題は、日本でも同じだ。重要なのは、技術の導入そのものではなく、顧客体験全体の設計だ。ここで学んだ最も重要な視点は、顧客に「選択肢」を必ず提供することの必要性だ。

チャットボット、有人チャット、電話――顧客が自分の状況に応じて選べるようにする。緊急度が高い顧客、複雑な問題を抱える顧客に対しては、いつでも人間のサポートにアクセスできる道を用意すべきだという主張であった。

これは「顧客体験」という抽象的な話ではなく、極めて実務的な設計の問題だ。有人チャットへのスムーズなエスカレーション、電話への誘導など、マルチチャネルの選択肢を前提とした設計が必須だ。

「Personalization」の現実的な意味

セッションの中で頻出した「Personalization(パーソナライゼーション)」という言葉について、私は当初、何かより高度な技術を指すのかと思っていた。しかし実際には、極めて現実的な話だった。

米国企業が言う「Personalization」とは、特別なことではなく、AI チャットボットが CRM やログイン情報などに接続している、という意味で OK だ。

つまり、顧客が問い合わせをした瞬間に、その顧客の過去の購入履歴、問い合わせ履歴、現在のステータス(会員ランク、契約内容等)が自動的に AI に渡される。

AI は「あなたは誰ですか?」「ご注文番号を教えてください」といった質問をせずに、本題に入れる。また、顧客の契約状況や最近のオーダー状況を理解した上で回答をするという意味になる

Zillow から登壇した Felicia Williams 氏(Senior Director, Support Services)は、この点を強調していた。

「住宅購入という重要な意思決定において、顧客は膨大な不安を抱えています。彼らがカスタマーサポートに連絡する時点で、すでに何度も Web サイトを訪れ、物件を比較し、複数のエージェントとやり取りしている。その文脈を理解せずに『どのようなご用件でしょうか』と聞くこと自体が、顧客体験を損なう」

これは技術的にはデータ連携の話だ。しかし、この「当たり前」の実装が、米国では既に標準になっている一方、日本ではまだ実現できていない企業が多い。

この「Personalization の現実」を目の当たりにして、データ統合の重要性を改めて認識した。単体のツール導入ではなく、顧客データベースとの深い統合が前提となる設計が今後は重要になりそうだ。

本質は「Human-like」ではなく「Human-liked」――今回の CCW を貫く核心的思想

Cantor 氏の一つの重要な指摘が、「Human-like(人間のような)」という表現への批判だった。この Human-like / Human-liked の違いは、今回の CCW 全体を貫く”思想の分岐点”だと私は感じた。

Human-like とは、AI を「人間っぽく」見せることに重きを置く考え方だ。

会話・感情・言葉遣いを人に近づける。名前のついたチャットボット、「お気持ちお察しします」「ご不便をおかけして申し訳ございません」といった定型文、絵文字やフレンドリーな口調―—これらはすべてHuman-like を追求した結果だ。

これは一見良さそうに思える。しかし Cantor 氏の指摘は痛烈だった。

「AI が人間のように振る舞うことが目的ではない。顧客に liked(好まれる)体験を提供できるかが本質だ。人間らしさを追求するあまり、実際に問題が解決されない体験を提供しているなら、それは失敗だ」

一方、Human-liked とは、人間が「これは助かる」「これで十分」と思える体験を設計する考え方だ。人間らしさは目的ではなく、結果として必要な場合のみ使う。

CCW で繰り返し語られていたのは、Human-liked な体験において重要視される 4 つの要素だった。

1. Accountability(責任) → その対応で「完結」するか |

感情表現は二の次だ、と Cantor 氏は強調した。

あるセッションで共有された具体例が、この違いを鮮明に示していた。

「私たちは生成 AI チャットボットに『共感的な表現』を学習させた。『ご不便をおかけして申し訳ございません😊』『お気持ちお察しします』といった言葉を適切なタイミングで返すようにした。しかし顧客満足度は上がらなかった。理由は単純だ。問題が解決していないからだ」

つまり、丁寧な言葉、共感フレーズ、フレンドリーなトーン――これらは「解決できる能力」があって初めて意味を持つ。

Lynch 氏が総括した一言が、今回の CCW で最も印象に残った表現の一つだ。

「Empathy without capability is insulting(解決能力のない共感は、むしろ失礼だ)」 表面的な共感は、顧客を侮辱する。顧客が求めているのは「理解されている」という感覚ではなく、「問題が解決される」という結果だ。

具体例で見ると、この違いはさらに明確になる。

❌Human-like に偏った体験: |

✅Human-liked な体験: |

米国の CC 業界では、「AI を人間のように振る舞わせる」ことよりも、「人間が好む結果を出せるか」が重視されていた。Human-like ではなく Human-liked。この言葉が、今回の CCW を象徴していた。

この思想転換は、特に日本市場にとって重要な示唆を含んでいる。日本は特に、丁寧さ・共感・言葉遣いを重視する文化だ。しかし、それが”解決能力を伴わない対応”だと逆効果になる。

日本企業に必要なのは「丁寧だが無力な対応」ではなく「静かに仕事を終わらせる仕組み」だ。

日本への示唆:3 年の差を埋めるために

今回の CCW で最も強く感じたのは、米国企業が既に「生成 AI の試行錯誤のフェーズ」を経て、次のステージに入っているという事実だ。

日本との差は 3 年程度だと感じる。10 年、5 年ではない。しかし、この 3 年は大きい。なぜなら、米国企業は既に「生成 AI 導入の失敗」や「成功」を経験し、そこから学んでいるからだ。

日本企業が今すぐ取り組むべきは、以下4項目だろう。

・盲目的な技術導入ではなく、具体的な顧客課題ベースでの検討 |

次回は、米国が既に進んでいる「Agentic AI」と「Voice AI」の具体的な実装事例を、 Dell、Macy’s、JetBlue の事例をもとに掘り下げる。そして、オペレーターの役割がどう変わっていくのか、その現実的な姿を報告したい。

【著者プロフィール】 |